Une approche de l’électronique « live »

Une étude de stratégies

José Luis Ferreira octobre 2011

octobre 2011DOI : https://dx.doi.org/10.56698/rfim.97

Résumés

Résumé

L’un des grands défis de la musique mixte est l’articulation entre les structures musicales de la partition et les sons générés électroniquement (générés par ordinateur ou transformés, en temps réel ou différé). Pour cela, nous dépendons à la fois de facteurs humains et technologiques. Ainsi, l’une des principales questions est : quelles stratégies peuvent être employées pour répondre aux besoins expressifs et musicaux du compositeur. Dans cet article, nous en discuterons quelques-unes, ainsi que la reconnaissance de l’interprète informatique et l’implémentation de ce que j’appelle le système Ohne.

Abstract

One of the greatest challenges of mixed music is the articulation between the musical structures of the score and the electronically generated sounds (computer generated or transformed, in real-time or deferred-time). For this we depend on the means to do it - the human factor and de technology factor. Hence, one of the main research question is: Which strategies could be used to insure a composer’s expressive and musical needs. In this paper it will be discussed just a few, such as the recognition of the electronics performer and the implementation of what I call the Ohne system.

Index

Index de mots-clés : temps différé, musique mixte, performance, temps réel.Index by keyword : Deferred-time, Mixed music, Performance, Real-time.

Notes de la rédaction

Cet article a été traduit de l’anglais par Guilherme Carvalho et Anne Sèdes.

Texte intégral

1. Contexte

1. 1. Interaction ou réaction

1Une grande part de mes œuvres en tant que compositeur peuvent être décrites comme de la musique mixte avec de l’électronique en temps réel. Cette approche peut facilement mener à ce qui est communément appelé de l’interaction en temps réel, mais dans mon cas ce serait inexact. Le terme de réaction, dans le sens d’une réponse à un stimulus, serait plus pertinent. En effet, dans la musique non-improvisée, les systèmes temps-réel tendent en général à être plus réactifs qu’interactifs.

2Cette assomption peut être connectée directement avec l’utilisation des guillemets autour du mot « live » dans le titre de cet article. Cela est directement lié à l’article de Marco Stroppa de 1999 (Stroppa 1999). Dans cet article, Stroppa formule une critique des systèmes temps-réel (également appelés à l’époque systèmes interactifs), dans la mesure où ils n’assurent pas une interaction musicale, et peuvent même contraindre l’expressivité d’une performance, soulignant que cette dernière devrait être le but principal. Je suis d’accord avec la plupart de ses positions, douze ans ont passé et ses remarques demeurent tout à fait pertinentes et précises. La possibilité d’une véritable interaction (au sens technologique du terme) n’est pas encore une réalité1, mais l’interaction musicale est évidemment déjà possible et réalisable. Peut-être le besoin d’être technologiquement interactif ne devrait-il pas être obligatoire, nous devrions plutôt nous occuper à faire une musique « vivante ».

1. 2. Contraste, fusion, expressivité

3Nous avons l’habitude de décrire l’usage des systèmes temps-réel ou temps-différé par leurs caractéristiques technologiques, leurs tempi libres ou fixés, ou leurs contraintes sur la performance. Évidemment, tout cela implique des différences à un niveau musical. Mais ces systèmes sont plus rarement décrits par leurs textures musicales ou leurs implications structurelles (Menezes 2002). Celles-ci peuvent être résumées de la sorte :

-

Les systèmes temps-différé sont décrits avec la possibilité d’obtenir un contraste avec la partie instrumentale (gamme plus large de possibilités sonores).

-

Les systèmes temps-réel visent la fusion2 entre les deux parties (les possibilités sonores dépendent directement de la partie instrumentale).

4Bien sûr, ce ne sont pas des principes absolus. Les systèmes temps-réel peuvent mettre en œuvre des textures contrastantes (par exemple en utilisant un granulateur), certaines œuvres en temps différé parient sur la fusion (par exemple, Kontakte de Stockhausen), et il est possible aujourd’hui combiner les deux systèmes.

5Mais la question de l’expressivité musicale (ou de son absence) apparaît à la fois dans des systèmes temps-différé et temps-réel. Dans ces derniers, lorsque l’on utilise un système de suivi de partition pour déclencher des évènements, l’interprète est face à différentes contraintes. L’obligation de jouer aussi précisément que possible3 pour ne pas provoquer de comportement erratique de la machine peut aboutir à une performance rigide et mécanique, mettant en danger l’expression musicale (Stroppa 1999). Les deux systèmes peuvent devenir une sorte de « camisole de force » pour une performance expressive. En fait, il s’agit d’un compromis assez commun en musique,

If the inner liveliness of electronic music is fortunately not the property of any specific technological system, it is nevertheless influenced by a system’s inherent drawbacks one must eventually always cope with. Devising the best compromise is sometimes an arduous task (Ibid.).

1. 3. Temps réel et temps différé

6En 2010, à cause de différentes contraintes technologiques, j’ai composé ma première pièce mixte en temps différé. Il s’agit de Metha, pour basson seul et sons pré-enregistrés et traités. De façon surprenante, certaines des caractéristiques que je recherche toujours dans un système temps-réel, en particulier la fusion entre les parties instrumentale et électronique, furent assez faciles à réaliser.

7En fait, j’ai l’habitude de travailler avec des systèmes temps-réel, plus précisément pour traiter le son produit par l’interprète au moment même de la performance. Dans Metha, j’ai légèrement dévié de cette approche : j’ai utilisé comme matériau sonore un enregistrement du basson fait au préalable.

8Ainsi, j’ai appliqué des traitements et des transformations du son, ainsi que des déviations temporelles relativement petites (essentiellement pour construire des canons à l’octave). « Pas à pas », j’ai créé une œuvre en temps différé avec des caractéristiques typiques d’un système temps-réel. Des structures de contraste et des textures sont également utilisées, et il serait assez complexe de les construire uniquement avec un système temps-réel.

9Pour la performance elle-même, toutes les questions de synchronisation possibles furent résolues par l’utilisation de repères musicaux. Encore une fois, j’ai été surpris par la performance. L’interprète a déclaré n’avoir senti pas plus de contrainte qu’en jouant accompagné par un pianiste. Pendant l’exécution, le public pouvait ressentir le dialogue – l’interaction – entre interprète et électronique. Encore ce mot, interaction ! Employé maintenant avec un sens différent : interaction musicale. Néanmoins, il semble paradoxal qu’un système temps-différé, généralement considéré comme contraignant ou dépourvu d’interaction technologique, puisse sonner bien plus « interactif » ou musicalement intégré qu’un système temps-réel développé pour ce but spécifique.

10Tout cela m’a amené à repenser les stratégies que je pourrais utiliser dans le futur, notamment le rôle combiné de la technologie et des ressources de l’être humain. Je développerai cela dans la suite de l’article.

2. Sur les interprètes et la performance

2. 1. L’interprète informatique

11La manière la plus simple d’obtenir cette interaction musicale consiste à intégrer le facteur humain qui, la plupart du temps, existe déjà – c’est « le musicien en charge de la projection sonore », « l’assistant musical », cette « personne en plus » ou, comme je l’appelle, l’interprète informatique4. Pourquoi avons-nous besoin d’un interprète plutôt que d’un technicien ? Bien des caractéristiques d’une œuvre de musique mixte peuvent être pleinement automatisées avec la programmation : espace, niveau (ou) volume, points de synchronisation et déclenchement du démarrage en sont quelques-unes. Mais pour être vraiment efficaces, ces caractéristiques peuvent normalement être reprises en main « in loco » par un musicien qui a la capacité de veiller sur l’état du système (si nécessaire) et de suivre le flux musical en ajustant ou en reprenant le contrôle de certains paramètres lorsqu’il y a lieu. Les décisions de ce musicien (même si elles ne portent que sur le volume) peuvent amener l’interprète sur scène à réagir.

2. 2. Défis dans la performance électronique

12Au fil des années, j’ai eu l’occasion d’être l’interprète informatique de pièces mixtes telles que Harmónicos et SaxBlue du compositeur Portugais Jorge Peixinho. Ces œuvres, qui dépendent à l’origine de matériel analogique5, furent créées spécifiquement pour les caractéristiques et possibilités d’un magnétophone à bande dans une performance en direct. Avec l’utilisation répandue des technologies numériques, il est difficile de nos jours d’avoir accès aux technologies analogiques, devenues obsolètes. « La préservation de la musique électronique en temps réel est un problème auquel compositeurs et interprètes sont confrontés depuis toujours. De plus, paradoxalement, l’introduction des technologies numériques a contribué à produire des œuvres encore plus périssables, alors que les dispositifs analogiques deviennent plus difficiles à trouver et que les dispositifs numériques changent tous les jours »(Sousa Dias 2009). Le passage ou recasting (Chadabe 2001) de ces œuvres des moyens analogiques aux moyens numériques est pleinement décrit dans (Sousa Dias 2009).

13Dans la version numérique de Harmónicos, l’interprétation informatique est assez simple, pas très différente de l’interprétation d’une œuvre en temps différé. Les décisions-clé doivent être prises avant la performance, en l’occurrence la panoramisation du délai, sa durée (entre six et huit secondes, comme demandé par le compositeur dans la notice d’exécution) et la possibilité d’émuler un vrai magnétophone à bande. Habituellement, ces décisions sont prises en accord avec le pianiste. L’utilisation effective de l’émulation du magnétophone à bande, qui se sert d’un filtre passe-bas pour imiter la perte de qualité inhérente à un enregistrement magnétique en temps réel, est en soi une décision esthétique importante : avec la simulation numérique, nous pouvons probablement recréer l’idée originale de la pièce, telle que le compositeur l’a voulue, mais nous ne recréons certainement pas les mêmes conditions d’écoute de l’œuvre elle-même telle qu’elle a été jouée lorsqu’elle dépendait d’un matériel analogique6. Pour obtenir cela, nous devrions aller encore plus loin et créer la possibilité de simuler l’instabilité du dispositif et les probables fluctuations de la vitesse de la bande dues à la distance entre les magnétophones7. Cela ajouterait certainement un charme différent à la pièce.

14Dans SaxBlue, la performance soulève des questions différentes8. Sur ce projet, Sousa Dias a inclu une simulation très fidèle de la chambre à écho Korg SE 500 dans le patch principal – ce qui permet l’utilisation de ce système numérique pour d’autres œuvres musicales9. Ce n’est pas la meilleure interface pour une performance informatique, mais il y a une bonne raison à cela. La section Korg SE 500 du patch peut être contrôlée par le saxophoniste (avec des contrôleurs MIDI, dont une pédale standard10), comme c’était le cas pour la version originale, laissant le contrôle de la balance et de la réverbération à l’interprète informatique.

15Cette interprétation soulève aussi quelques questions esthétiques, notamment quant à l’utilisation de la réverbération. Dans ses notes, Peixinho ne fait pas référence à l’utilisation d’un module de réverbération, mais nous savons qu’il a parfaitement accepté la seule version publiée, interprétée par Daniel Kientzy11, avec une réverbération ajoutée. Ici, je présente l’argument contraire à celui utilisé au préalable pour Harmónicos. Devrions-nous ajouter des caractéristiques qui pourraient améliorer ou élargir l’efficacité d’une œuvre musicale ? Et pourquoi pas ? Comme musicien, je me sens obligé de considérer, comme pour tout autre genre de musique, que la musique électronique devrait être abordée de façon plus malléable quant à la performance. Je ne considère ici pas la technologie elle-même, mais simplement la façon dont nous, humains, travaillons avec elle. Ces questions demeurent ouvertes, elles ont des implications musicales, expressives et esthétiques que tout interprète devrait considérer quand il a affaire à une œuvre musicale.

16Un exemple d’une interprétation informatique exigeante est King George I, as Seen in Schiaparelli’s Telescope, Sailing his Barge upon Martian Canals12, de Luís Tinoco, pour flûte, percussion et électronique en temps réel. Cette pièce fut écrite comme un duo, mais la seule façon possible de l’interpréter est de considérer un troisième interprète pour l’électronique en temps réel. L’électronique consiste en un ensemble intriqué de canons d’après partie de flûte. En raison de l’écriture instrumentale de cette pièce13, il est pour ainsi dire impossible d’utiliser un suiveur de hauteur ou de tempo qui permettrait un quelconque comportement réactif de la partie électronique. Pour interpréter avec succès cette pièce, l’interprète informatique doit interagir avec les interprètes sur scène comme s’il était un musicien sur scène qui attend ses entrées.

2. 3. Sur l’usage du click-track

17Il y a aujourd’hui une pratique, lors de l’exécution de musique en temps différé, d’imposer un click-track à l’interprète lorsque des problèmes de synchronisation apparaissent. La plupart des compositeurs soit considère cette possibilité comme un acquis, sans mettre en question que cette solution puisse mener à des contraintes pour la performance, soit accepte un compromis entre précision et expression. En général, lorsqu’on leur demande leur sentiment quant à jouer avec un click-track, les interprètes tendent à le rejeter et disent qu’ils ne peuvent pas « entendre » leur propre instrument ou l’ensemble de l’acoustique et de l’électronique, et toutes les contraintes que soulèvent ces facteurs, mais ils acceptent souvent de l’utiliser, comme un compromis, au nom de la précision.

18Il y a un point particulier sur lequel je ne peux pas être d’accord dans l’article de Stroppa mentionné ci-dessus, il s’agit de la « facilité » de l’utilisation d’un click-track.

A performer at ease with a click track will find other ways to express his or her interpretive choices (Stroppa 1999).

19Mais Bruno Repp, chercheur en psychologie de la musique, dans un article sur la manière dont les interprètes organisent la structure temporelle expressive autour d’une pulsation de base voulue, établit que :

In an Expressive music performance, the local tempo varies continuously and often asymmetrically around an implied (nominally constant) basic tempo (Repp 1994).

20et nous donne un exemple spécifique :

When the music is relatively slow [...] the tempo is not so easily determined. Expression (may) call for considerable deviations from rigidity in timing, and these deviations are more often lengthenings than shortenings of beat durations, because ritardandi have the important function of marking structural boundaries at several levels (Ibid.).

21Dans un tempo rapide, selon le type de structures musicales, un accelerando non écrit peut également servir comme un outil expressif pour l’interprète. Quoique l’approche de Repp concerne spécifiquement la musique du xixe siècle, de mon point de vue elle peut intuitivement (et humainement) être appliquée à la musique contemporaine.

22Jusqu’ici il est possible d’observer que deux composantes importantes de cette étude des stratégies sont les interprètes et le moment de la performance – l’interaction musicale. J’essaie de la décrire comme similaire à de la musique de chambre sur le moment.

3. Le système Ohne

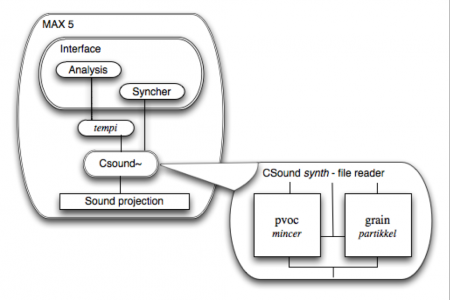

23En 2010, j’ai commencé le développement d’un système, dont le concept n’est en rien neuf, qui consiste en un lecteur de fichiers qui peut être synchronisé avec les tempi de l’interprète sans compromettre la qualité et le timbre du fichier son. Le cœur du système peut être sommairement décrit comme l’utilisation d’un vocodeur de phase14 combiné à un synthétiseur granulaire pour lire le fichier son. Le vocodeur de phase permet de compresser ou d’étendre la durée d’un signal sans en affecter la hauteur. L’une des caractéristiques de cette technique est un son rendu flou15 quand une extension temporelle plus importante a lieu, et il est possible de prévoir les conditions pour cela quand, par exemple, l’interprète décide de faire un rallentando dans une section particulière de la pièce. Pour éviter cet effet, le système fait un fondu-enchaîné vers un granulateur qui peut éviter cette distorsion timbrale, car il a la possibilité de lire un fichier de manière non-périodique (dispersée) qui produit un timbre beaucoup plus fidèle (dans ces conditions extrêmes) que la technique du vocodeur de phase. Ces techniques on été programmées dans le langage du synthétiseur Csound16 en utilisant les abstractions mincer17 (vocodeur de phase) et partikkel18 (synthèse granulaire).

24L’abstraction mincer est assez récente dans Csound et démontre une très bonne performance quant à la préservation du timbre de son fichier source. Étant donné les difficultés de Csound en tant qu’environnement temps-réel et la qualité généralement pauvre du rendu de synthèse sonore dans le programme Max19, j’ai décidé de les combiner grâce à l’objet csound~20, qui permet l’utilisation du moteur sonore de Csound à l’intérieur de Max. Cette combinaison s’est avérée très efficace pour contrôler des synthèses de haute performance et pour économiser en CPU. Le schéma ci-dessous (Fig. 1) présente un diagramme fonctionnel simple de ce que va devenir le système Ohne21. L’interface reste à implémenter et il y aura, probablement, plusieurs versions selon les différents besoins d’interaction entre les parties instrumentale et électronique.

25Avec ce système, il sera possible d’apporter une certaine liberté de performance proche de l’interaction entre les interprètes dans la musique de chambre. En mettant de côté la « camisole de force » du click-track citée plus haut et en obtenant la possibilité de fluctuations de tempo inhérentes à une performance humaine, il contribuera certainement à un renouveau de l’expressivité et de la musicalité de la musique en temps différé.

Figure 1

Diagramme fonctionnel du système Ohne

4. Directions futures – Metha – conversion temps-réel : pas à pas

26Lorsqu’il approche l’électronique d’une pièce musicale (qu’elle soit temps-réel ou temps-différé), un compositeur choisit le système qui répond le mieux à ses besoins musicaux. Il arrive assez souvent que les décisions musicales finissent par dépendre directement du système choisi. Cela peut représenter un piège important (Bachratá 2010). Mas il revient au compositeur de gérer cela et de décider à quel degré ses décisions musicales peuvent ou non être influencées par un système22. Je partage le point de vue de Daniel Schachter à ce sujet :

Technology should not become itself an end, but a key to expand the expressiveness of musical languages (Schachter 2007).

27Parfois la meilleure solution à cela est de créer un système mixte, ou une combinaison de plusieurs systèmes qui peuvent garantir les besoins expressifs et musicaux d’un compositeur.

28L’essentiel de la conversion temps-réel de Metha n’est pas d’améliorer son expressivité et son interaction musicale, déjà évoquées. Sa reproduction, en plusieurs pas vers une conversion temps-réel complète, permettra une étude systématique et analytique sur l’éventail plus large de solutions qu’un système (ou une combinaison de systèmes) peut apporter. Ces pas sont les suivants :

-

Développement su système Ohne – contrôle en temps réel de la vitesse/tempi de l’électronique fixe ;

-

Division du fichier son principal en repères musicaux à déclencher lors d’une performance temps-réel ;

-

Réorganisation du fichier son principal afin de le diviser en structures morphologiques, à mixer et déclencher lors d’une performance temps-réel23;

-

Conversion temps-réel totale — comme la source sonore de l’électronique fixe est le fichier de la partie de basson enregistré à l’avance, il sera possible d’obtenir un traitement temps-réel de cette œuvre ;

29Chacun de ces pas présente différentes possibilités, contraintes et solutions, et enrichira certainement la palette des stratégies disponibles aux compositeurs.

Conclusion

30Le rôle combiné de la technologie et de ressources de l’être humain, inhérent à ce genre musical, implique souvent le développement de stratégies qui devraient prendre en compte les différents éléments discutés ici. Ainsi, pour penser des stratégies différentes et efficaces pour créer de la musique mixte, nous dépendons du facteur humain et du facteur technologique. Le premier inclut les interprètes (instrumental et informatique) et le compositeur. Le second concerne les deux instruments – l’acoustique et le numérique. Ceux-ci sont liés par ce que l’on peut généralement appeler des algorithmes : la partition, l’application programmée (ou le système numérique) et parfois les notices (techniques ou d’exécution) fournies par le compositeur . La reconnaissance de l’interprète informatique, et l’implémentation du système Ohne sont quelques-unes des stratégies qui peuvent améliorer la performance de pièces mixtes « live ».

Bibliographie

Bachratá, P. (2010). “Gesture Interaction in Music for Instruments and Electroacoustic Sounds”. Aveiro, Universidade de Aveiro. Doctoral thesis.

Chadabe, J. (2001). “Preserving Performances of Electronic Music.” Journal of New Music Research 40(4): 303-305.

Menezes, F. (2002). “For a morphology of interaction.” Organised Sound 7(3): 305-311.

Repp, B. H. (1994). “On Determining the Basic Tempo of an expressive Music Performance.” Psychology of Music(22): 157-167.

Schachter, D. (2007). “Towards New Models for the Construction of Interactive Electroacoustic Music Discourse.” Organised Sound 12(1): 67-78.

Sousa Dias, A. (2009). “Case studies in live electronic music preservation: Recasting Jorge Peixinho’s Harmónicos (1967-1986) and Sax-Blue (1984-1992).” Citar Journal(1): 38-47.

Stroppa, M. (1999). “Live electronics or... live music? Towards a critique of interaction.” Contemporary Music Review 18(3) : 41-77.

Notes

1 Ce sera le cas probablement lorsque nous aurons une intelligence artificielle pleinement développée et accessible.

2 Le mot fusion est pris dans un sens large. Il peut inclure des caractéristiques comme la synchronisation et toute sorte de données extraites du matériau sonore en direct.

3 Sans ce que l’on peut appeler des « déviations dans la performance », comme des vibratos (plus larges) ou des imperfections dans un passage très rapide.

4 NdE : on pourrait ici se référer à la dénomination RIM (réalisateur en informatique musicale)

5 Les deux magnétophones disposés à distance pour obtenir un effet de délai entre 6 et 8 secondes dans Harmónicos, et le Korg SE 500 (chambre d’écho) pour Saxblue.

6 Nous pouvons faire un parallèle avec la nouvelle musique ancienne depuis le début des années 1990. Les interprètes tentent souvent de reproduire aussi fidèlement que possible les conditions de la période baroque, par exemple, en utilisant les mêmes techniques instrumentales, des reproductions d’instruments et les mêmes effectifs et dispositions.

7 2.28 à 3.04 mètres.

8 La partie de saxophone présente également certains problèmes quant au manque d’informations sur la partie temps-réel.

9 Comme, par exemple, pour la performance de VARIANT-INVARIANT (1982) du compositeur Costin Miereanu – cette pièce a inspiré J. Peixinho à écrire SaxBlue.

10 La simulation de la pédale S-2 Dual est inclue dans le patch principal.

11 À qui l’œuvre est dédiée.

12 Tinoco, L., 2008, King George I, as Seen in Schiaparelli’s Telescope, Sailing his Barge upon Martian Canals, commande de RTP/Antena 2 pour flûte et percussion. Ed. University of York Music Press.

13 L’essentiel de la partie de flûte est écrite avec des trémolos arpégés de doigtés non-standard éoliens, des multiphoniques et des whistle tones.

14 Dudas, R., Lippe, C. 2006, The phase vocoder, http://cycling74.com/2006/11/02.

15 Cet artéfact, aussi appelé « frame effect », est causé par le saut d’une fenêtre d’analyse à la suivante.

16 Vercoe, B., Csound. 1980, Massachusetts Institute of Technology.

17 Conçu parVictor Lazzarini pour CSound 5.12.

18 Conçu parThom Johnson, Torgeir Strand Henriksen et Øyvind Brandtsegg pour CSound 5.06.

20 Conçu par Davis Pyon pour Csound 5.

21 Le mot allemand « Ohne » peut être traduit par « sans ».

22 Mais les compositeurs ont souvent l’expérience de situations conditionnées (par des contraintes technologiques ou des conditions imposées par une commande, par exemple) qui peuvent les mener à choisir un système, indépendamment de leurs besoins musicaux.

23 Influenced by Marco Stroppa’s Virtual Performer concept.